Aplikacja TikTok, na której przebywa dziś 1.5 mln dzieci w wieku 7-12 lat*, ma kluczową przewagę nad każdym dorosłym: widzi zachowanie dziecka w mikroskali i w czasie rzeczywistym, bez przerw, bez wstydu, bez autocenzury. Algorytm widzi wszystko: ile sekund dziecko patrzy, przy czym zwalnia przewijanie, do czego wraca, co ogląda do końca, co tylko musnęło kciukiem, a przy czym zatrzymało się na chwilę za długo. Ta aplikacja nie pyta dziecka o samopoczucie. Wystarczy jej to, co wskazuje skrolowanie.

Jedna sekunda dłużej na filmie. Cofnięcie. Obejrzenie do końca. Wejście w komentarze. Zapisanie. To są sygnały. Algorytm nie rozumie świata jak człowiek, nie widzi rodziny, szkoły, historii, presji rówieśniczej. Widzi wzór. Wzór podpowiada: „to jest temat, który działa”. Potem dzieje się rzecz, którą wielu dorosłych myli z przypadkiem: platforma zaczyna pokazywać dziecku podobne treści. Nie dlatego, że „ktoś coś ustawił”, tylko dlatego, że ten system żyje z utrzymywania uwagi. Pułapka polega na tym, że dorosły próbuje ocenić sytuację po tym, co widać na profilu. Profile dzieci często wyglądają zwyczajnie: memy, śmieszne scenki, muzyka, sport, coś z trendów. Taki obraz uspokaja. Taki obraz bywa kompletnie nieadekwatny do tego, co dziecko naprawdę konsumuje w trybie „Dla Ciebie”, co zapisuje, do czego wraca i co ogląda, gdy nikt nie patrzy.

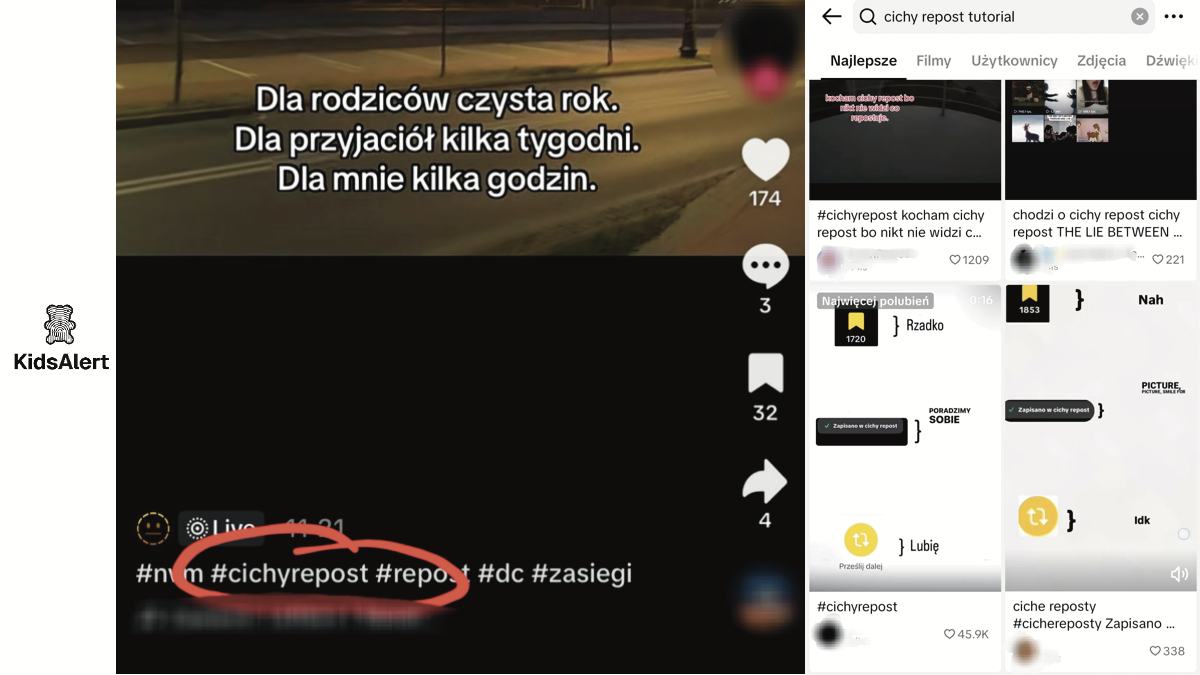

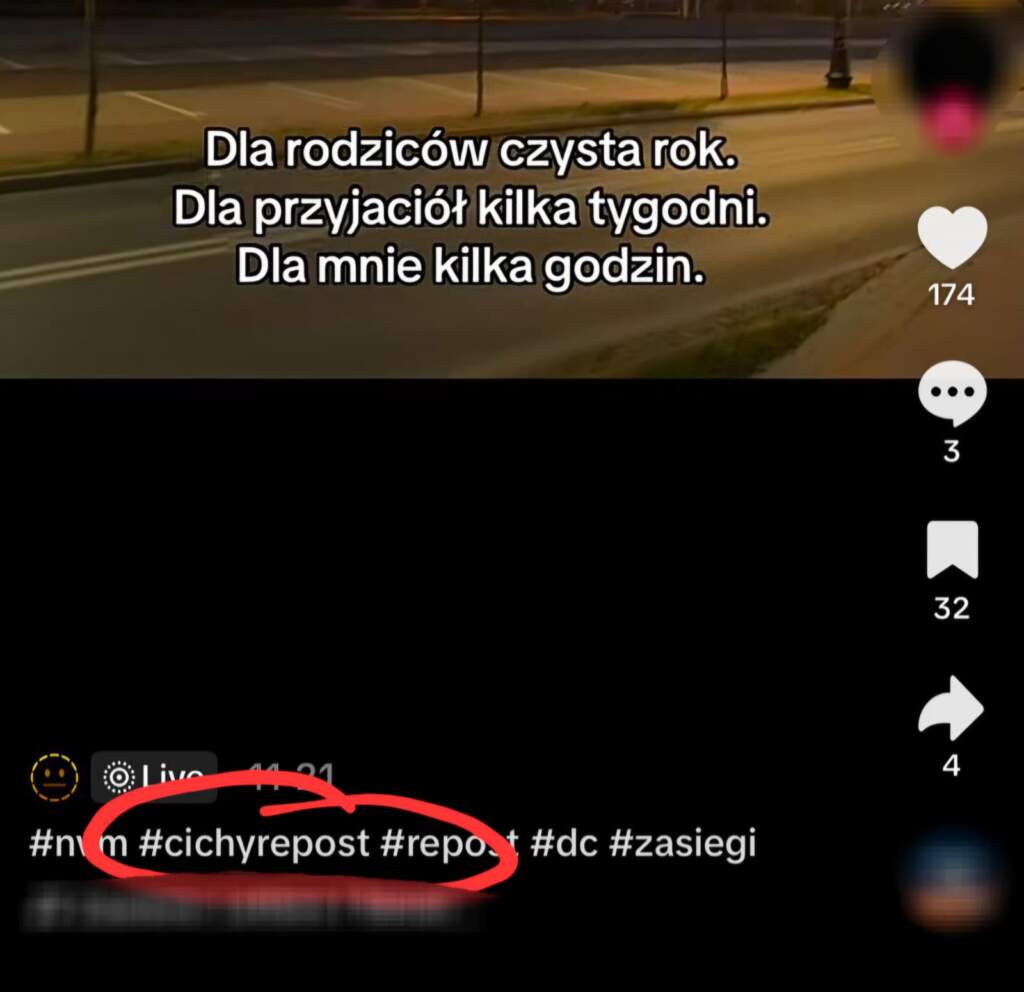

Treści autodestrukcyjne rzadko dziś wyglądają jak wielki neon: „uwaga, to zagrożenie”. Zbyt dużo osób myśli o tym temacie jak o filmach z lat 90., gdzie problem był dosłowny, krzykliwy i łatwy do rozpoznania. W realnym feedzie bywa inaczej: spokojny montaż, estetyka „ładnego smutku”, nocny kadr, muzyka, która robi klimat, krótkie zdanie, które można odczytać na wiele sposobów. Dorosły widzi melancholię. Nastolatek w kryzysie widzi lustro. Algorytm widzi „zatrzymanie” i dostaje potwierdzenie: „podsuń więcej”. Komentarze robią w tym układzie „cichą robotę”. Często dopowiadają sens, budują kod, normalizują temat, doklejają społeczny kontekst. Dorosły może mieć wrażenie, że ogląda neutralny film o emocjach. W komentarzach potrafi się okazać, że grupa rówieśnicza czyta to zupełnie inaczej. Taki mechanizm jest zdradliwy, bo nie da się go wyciąć prostym filtrem na słowa-klucze. Przekaz nie zawsze jest w słowach. Przekaz siedzi w kontekście.

Najbardziej niebezpieczna część nie jest pojedynczym filmem. Najbardziej niebezpieczna jest pętla. Pojedynczy film da się przewinąć. Pojedynczy film da się zgłosić. Pojedynczy film da się zablokować. Pętla działa jak echo: temat wraca, gęstnieje, zaczyna budować klimat, nie daje oddechu, podkręca emocje, utrwala nastrój. W kryzysie psychicznym to potrafi działać jak wzmacniacz: dziecko nie tylko „ma gorszy dzień”, ono dostaje tysiące mikro-powtórzeń, że gorszy dzień jest normalny, powszechny, „fajny” w swojej estetyce, a czasem wręcz nagradzany uwagą. Dochodzi jeszcze walidacja liczbami. Serduszka, komentarze, zapisy, udostępnienia. Dorośli lubią to bagatelizować, bo brzmi „internetowo”. Problem polega na tym, że w wieku nastoletnim liczby są komunikatem społecznym: „to jest ważne”, „to ma sens”, „inni też tak czują”. W kryzysie taki komunikat bywa bardzo silny, bo daje iluzję wspólnoty, nawet wtedy, gdy ta wspólnota jest zbudowana nie wokół pomocy, tylko wokół rezygnacji.

W tym miejscu pojawia się drugi silnik dystrybucji. Algorytm to jedno. Rówieśnicy to drugie. Pętli algorytmicznej nie da się wyłączyć jednym ruchem, szczególnie gdy treści zaczynają krążyć „po klasie”, „po grupie”, „po znajomych”. Tam zaczyna się temat, który jest niewygodny dla dorosłych, bo podważa prosty nawyk kontroli: CICHY REPOST.

CICHY REPOST

Dziecko ma w klasie koleżankę, która przynosi kartkę z czymś dziwnym – niekoniecznie wulgarnym, raczej „mocnym”, emocjonalnym, podszytym buntem. Kartka idzie z rąk do rąk. Nauczyciel nic nie widzi, rodzic nic nie widzi, bo kartka nie wisi na tablicy, nie jest przyklejona do drzwi, nie krąży po szkolnym korytarzu. Kartka krąży w ławkach.

To jest sedno „cichego repostu”. Treści potrafią żyć intensywnie poza przestrzenią publiczną i poza tym, co dorosły widzi na profilu. Repost w najprostszym znaczeniu jest poleceniem treści dalej: „zobacz to”, tylko bez słów, jednym ruchem palca. Sama funkcja nie brzmi jak dramat, dopóki dotyczy memów, sportu czy muzyki. Dramat zaczyna się w momencie, gdy treść wrażliwa, ciężka albo autodestrukcyjna dostaje pieczątkę rówieśniczą: „to jest warte obejrzenia”. Materiał przestaje być anonimowym znaleziskiem z algorytmu. Staje się przekazem „od człowieka”. W wieku nastoletnim ta różnica ma znaczenie, którego dorośli często nie doceniają. Treść od algorytmu można zignorować, bo algorytm jest nikim. Treść od znajomego jest „z naszej paczki”, „z naszej klasy”, „z naszej bańki”. Takie polecenie ma ciężar społeczny, a ciężar społeczny jest paliwem dla normalizacji. Normalizacja jest jednym z najgroźniejszych mechanizmów w obszarze treści autodestrukcyjnych, bo przesuwa granice: to, co wczoraj było „dziwne”, dziś jest „rel”, a jutro jest „codzienne”.

Pojęcie „cichy repost” funkcjonuje jednak nie tylko jako „podeślij dalej”. W praktyce jest to całe podejście do dystrybucji i do chowania śladów, które mogłyby zwrócić uwagę dorosłego. Dzieciaki nie muszą być „sprytne” w sensie technicznym. Wystarczy, że są uważne społecznie. Widzą, że rodzice zaglądają na profile. Widzą, że rodzic ma konto „żeby widzieć”. Widzą, że rodzic w stresie zaczyna grzebać: „kogo obserwujesz”, „co polubiłeś”, „co udostępniłeś”, „co masz na profilu”. Szczytem jest „kontrola rodzicielska” którą TikTok złudnie podaje opiekunom pod nos w komunikatach reklamowych, jednak „chichego repostu” jak i wyfiltrowania treści niebezpiecznych nie oferuje, ale to temat na osobne opracowanie.

W ten sposób powstają dwa równoległe światy. Świat „na widoku” wygląda normalnie. Bezpiecznie. Nic tam nie krzyczy. Nie ma materiałów, które aż proszą się o reakcję rodzica. Profil świeci czystością: brak podejrzanych lajków, brak kont „z mrokiem”, brak udostępnień, brak wprost wypowiedzianych treści. Dla dorosłego to dowód, że „jest okej”. Świat „w środku” to miejsce, w którym działa właściwe życie algorytmu: feed, do którego dziecko wraca, treści, które zapisuje, kolekcje, które buduje, powtarzalny klimat, który sobie dokłada. Ten świat nie musi zostawiać publicznych śladów. Ten świat może być prywatny. Ten świat potrafi być całkowicie niewidoczny z zewnątrz.

Tu dochodzimy do rzeczy, którą trzeba rodzicom powiedzieć bez owijania: dziecko może mieć na TikToku zapisane i posegregowane treści w prywatnych kolekcjach, których opiekun nie zobaczy, nawet jeśli patrzy na profil bardzo uważnie. Prywatna kolekcja działa jak zamknięta szuflada. Nie chodzi o „sekrety dla zasady”. Chodzi o narzędzie, które w praktyce pozwala budować własną bibliotekę materiałów i wracać do niej po cichu, bez widocznej historii na profilu (do historii wyszukiwania dziecka kontrola rodzicielska też nie zezwala…).

Taki mechanizm ma trzy konsekwencje w temacie bezpieczeństwa dzieciaków na TikToku

Pierwsza konsekwencja: „brak śladów” nie oznacza „brak kontaktu”. Rodzic może patrzeć na profil i widzieć brak lajków, brak udostępnień, brak „dziwnych” obserwowanych kont, a mimo to dziecko może intensywnie konsumować i zapisywać treści. Brak śladów oznacza często tylko tyle, że dziecko nauczyło się nie zostawiać sygnałów na wierzchu.

Druga konsekwencja: cichy repost i prywatne zapisy umożliwiają trening algorytmu po cichu. Algorytm nie potrzebuje publicznych lajków na profilu. Wystarczy mu zachowanie: zatrzymanie, obejrzenie, powrót, zapis, wejście w komentarze. Dziecko może więc budować swój feed w stronę określonych treści, a dorosły zobaczy tylko „ładny profil”. Właśnie dlatego tak często mija się obraz profilu z obrazem rzeczywistości.

Trzecia konsekwencja: obieg rówieśniczy staje się praktycznie niewykrywalny dla kogoś, kto obserwuje konto z zewnątrz. Treść może krążyć „po znajomych”, a później znikać z widocznych miejsc. Materiał może być zapisany i odłożony do prywatnej kolekcji, co w praktyce utrudnia jakiekolwiek sensowne „sprawdzanie”, jeśli opiekun nie ma bezpośredniego dostępu do konta dziecka.

To jest moment, w którym warto obalić popularne złudzenie: „zainstaluję kontrolę rodzicielską i będę widział”. Kontrola rodzicielska brzmi jak antidotum. W praktyce często daje głównie poczucie, że „coś jest ustawione”. Narzędzia platformowe potrafią ograniczać czas, potrafią ustawiać pewne bariery, potrafią porządkować prywatność. Nie stanowią jednak pełnego wglądu w rzeczywisty obieg treści, szczególnie wtedy, gdy wchodzą prywatne zapisy, prywatne kolekcje i rówieśnicze podawanie dalej. To krzyk którego opiekun nie usłyszy, a dotyczy dziś setek tysięcy dzieci (tylko dwa losowe posty w temacie „cichego repostu” spośród tysięcy innych mają dziś zasięg 300 tysięcy wyświetleń).

Właśnie dlatego, według naszego zespołu cichy repost jest niewidzialnym, olbrzymim zagrożeniem. Nie wygląda jak zagrożenie. Wygląda jak prywatność. Wygląda jak „nic”. W kryzysie psychicznym to „nic” potrafi być korytarzem, którym wracają treści pogarszające stan dziecka. Rodzic patrzy na profil i widzi spokój. Dziecko wraca do zapisów i widzi ciężar. Ta asymetria jest najtrudniejsza do uchwycenia, bo uderza w podstawowy instynkt dorosłego: „jeśli jest źle, to powinno być widać”. „Cichy repost” kompletnie temu zaprzecza, „cichego repostu” nie widać.

Skąd ten tekst i dlaczego pokazuje esencję, a nie 27 stron raportu?

Na potrzeby aplikacji KidsAlert wykonałem konkretne rozeznanie zjawiska i sporządziłem obszerny raport wewnętrzny, który otrzymały służby. Ten artykuł jest jego publiczną wersją, która pokazuje esencję mechanizmu, bez ujawniania materiałów źródłowych i bez cytowania treści mogących szkodzić. Publikacja ma ułatwić zrozumienie rodzicom, który są biegli „w internecie” co dokładnie oznacza „niewidzialny obieg” i dlaczego profil dziecka bywa kiepskim wskaźnikiem tego, co naprawdę dzieje się w jego feedzie.

W sprawozdaniu zastosowano standardowe podejście badawcze KidsAlert, adekwatne do specyfiki algorytmu platformy. Były to badania panelowe na próbie dynamicznej, gdzie techniką było kodowanie ręczne, a jednostką analizy pojedynczy post wideo (lub zdjęcie) wraz z powiązanymi metadanymi: opisem, hasztagiem, dźwiękiem oraz kontekstem odbioru. Dobór materiału miał charakter celowy i nielosowy, ponieważ algorytm nie zachowuje się jak losowanie z urny, tylko reaguje na ekspozycję i interakcję. Kryterium włączenia do próby stanowiła algorytmiczna ekspozycja na treści o potencjale szkodliwym oraz metodyka kuli śnieżnej, w której kolejne elementy pojawiają się poprzez powiązania treści i zachowań użytkowników.

Najważniejsza rzecz, jaką ten tekst ma zostawić w głowie opiekuna, jest banalna, a mimo to często pomijana: „jak nie widzę, to nie ma” jest w tym temacie błędnym założeniem. Cichy repost, prywatne zapisy i prywatne kolekcje sprawiają, że część obiegu nie będzie widoczna dla rodzica oglądającego profil z zewnątrz, nawet jeśli robi to regularnie i z najlepszą intencją. Nawet jeśli robi to za pomocą kontroli rodzicielskiej. Brak widocznych „śladów” nie jest dowodem braku problemu. Bywa dowodem, że dziecko nauczyło się przeżywać i konsumować treści w trybie, który omija dorosły wzrok. Tekst nie ma straszyć, ma porządkować. Ryzyko w obszarze treści autodestrukcyjnych nie polega na tym, że „TikTok wprost namawia”. Ryzyko polega na pętli: algorytm podsuwa, rówieśnicy podają dalej, komentarze domykają sens, liczby normalizują przekaz, a możliwość zapisu i prywatnego kolekcjonowania sprawia, że obieg może trwać bez publicznego śladu. W kryzysie psychicznym taki układ potrafi przyspieszać pogorszenie nastroju, wzmacniać bezradność i izolować dziecko w jego własnym „klimacie”.

W sytuacjach, w których pojawia się realne zagrożenie dla zdrowia lub życia, najważniejsze jest szybkie wsparcie człowieka, nie kolejna walka z aplikacją. Telefon zaufania dla dzieci i młodzieży: 116 111. Centrum Wsparcia w kryzysie psychicznym: 800 70 2222. W sytuacji bezpośredniego zagrożenia: 112.

*raport Internet dzieci 2025, Gemius

Autor: Łukasz Mituła

(artykuł opracowany na podstawie wewnętrznego raportu przygotowanego na potrzeby KidsAlert; publikacja pokazuje esencję zjawiska, bez ujawniania materiałów źródłowych i treści szkodliwych)